FramePackを使用するとVRAM6GBのマシンでも、ローカル環境で動画生成を行うことができると聞き、さっそく試してみました。

私のPCは、AIモデルとしてのスペックは高くないので、どの程度動くのか実験です。(モンハンワイルズの高画質推奨設定程度)

環境

Windows11 home

CPU Core i7 14700

メモリー 32GB

ビデオボード NVIDIA RTX 4060(8GB)

インストール

GitHubの次のサイトからダウンロードさせてもらいました。

lllyasviel/FramePack: Lets make video diffusion practical!

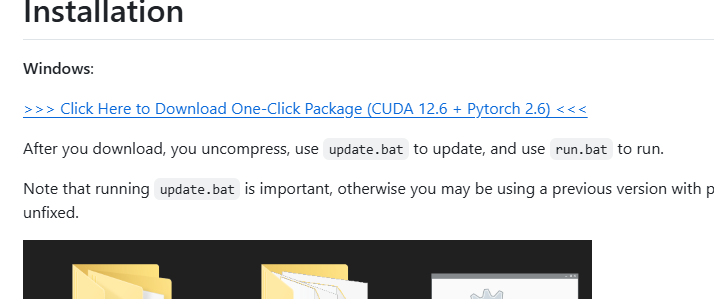

Readmeが丁寧に作られているので、この通りやっていけばトラブルなくインストールできました。

ワンクリックパッケージが用意されているので、ダウンロードして、実行するだけです。

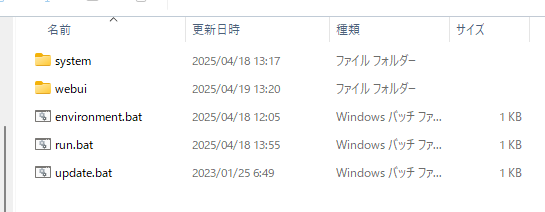

ダウンロードファイルを解凍した様子

解凍フォルダの

①update.bat を実行(最新バージョンにアップデートしてくれます)

②run.bat を実行(モデルのダウンロードを行うので、30分~1時間くらいかかります)

これだけです。

ダウンロードファイルサイズは45GBくらいでした。

実行時のコマンドプロンプトは次の通りです。

# ダウンロードしたファイルを解凍し、同フォルダに移動

C:\???\framepack_cu126_torch26 > dir

2025/04/18 12:05 270 environment.bat

2025/04/18 13:55 132 run.bat

2025/04/18 13:17 <DIR> system

2023/01/25 06:49 168 update.bat

2025/04/19 13:20 <DIR> webui

3 個のファイル 570 バイト

# update.batを実行

C:\???\framepack_cu126_torch26 > update.bat

Updating 1b371ad..743657e

HEAD is now at 1b371ad better gradio args for win

Updating 1b371ad..743657e

Fast-forward

README.md | 10 +++++++++-

demo_gradio.py | 15 ++++++++++-----

diffusers_helper/utils.py | 4 ++--

3 files changed, 21 insertions(+), 8 deletions(-)

続行するには何かキーを押してください . . .

# run.bat を実行

C:\???\framepack_cu126_torch26 > run.bat

Currently enabled native sdp backends: ['flash', 'math', 'mem_efficient', 'cudnn']

Xformers is not installed!

Flash Attn is not installed!

Sage Attn is not installed!

Namespace(share=False, server='127.0.0.1', port=None, inbrowser=True)

Free VRAM 6.9326171875 GB

High-VRAM Mode: False

config.json: 100%|█████████████████████████████████████████████████████████████████████| 766/766 [00:00<00:00, 768kB/s]

:

# これでWebUIが起動しますWebUIにアクセス

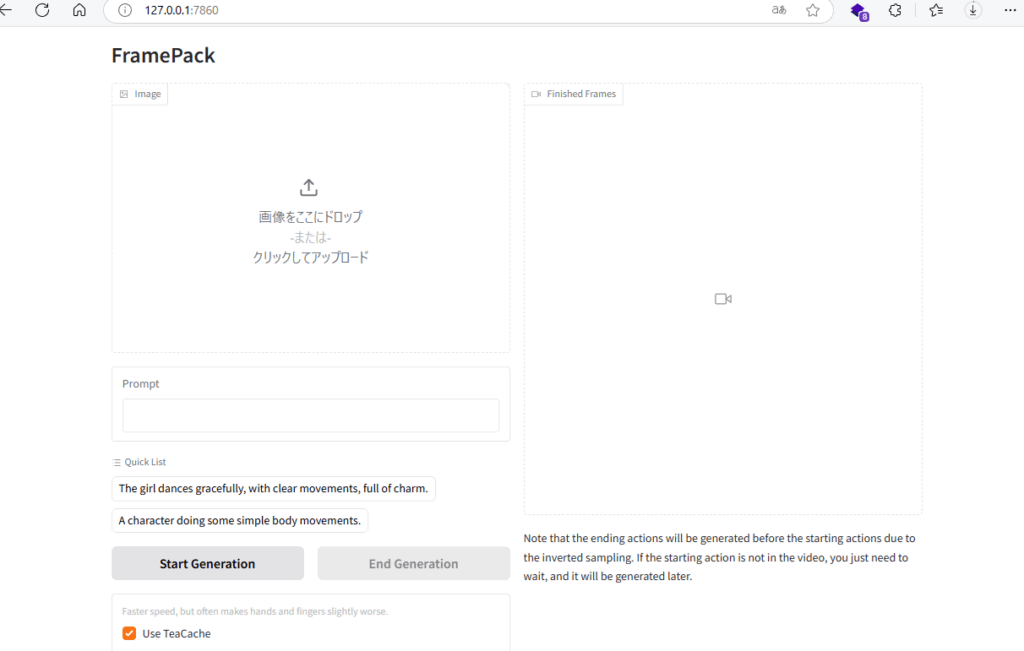

ブラウザから「http://127.0.0.1:7860/」にアクセスするとWebUIが開きます。

7860ポートを開放しているのですね。

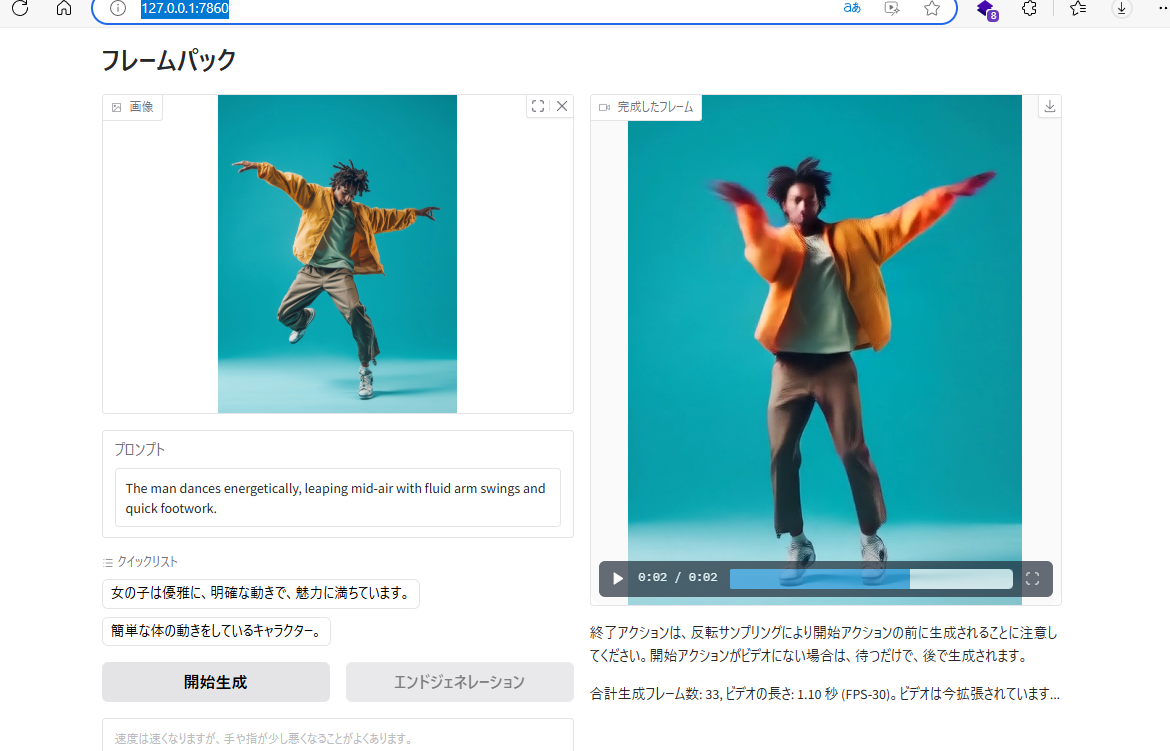

Readmeに書いてある手順で動画を生成しました。

①「画像をここにドロップ」と書かれている場所にサンプル画像をドラック

②プロンプトを入力

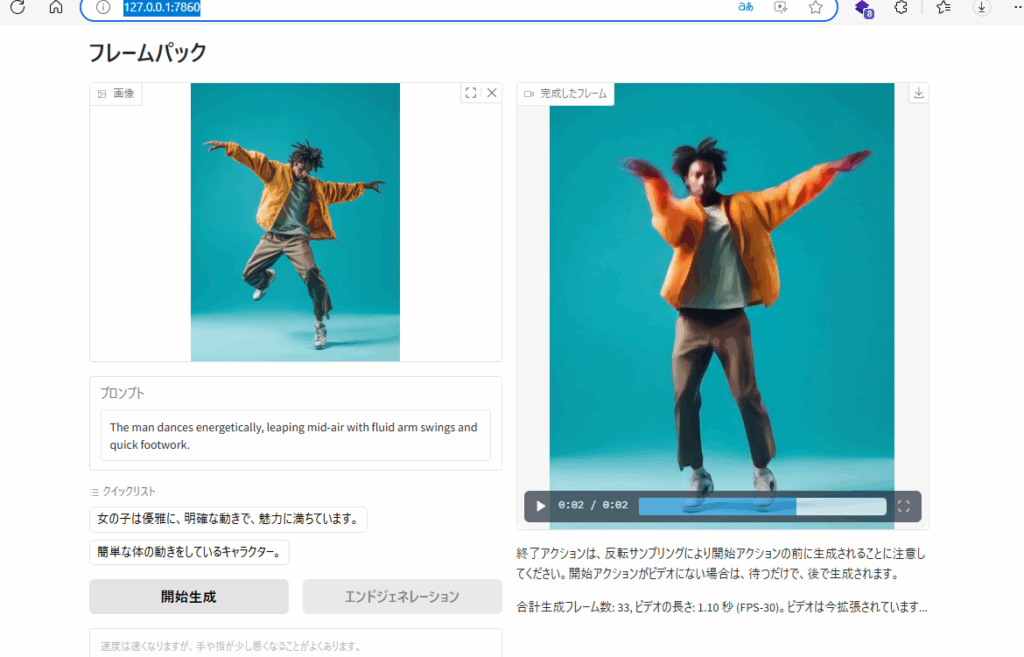

「The man dances energetically, leaping mid-air with fluid arm swings and quick footwork.」

※プロンプトは日本語入力に対応していないようです

③「Start Generation」をクリック

動画生成が始まるので待つだけです

サンプル画像から2.5秒の動画を生成したところ、30分位かかりました。

生成した動画 mp4形式 2.5秒 ファイルサイズ 946KB

静止画であるサンプル画像から、ローカル環境でここまでの動画を作れるのは驚きました。

感じたこと

服の質感 レザー風の上着がフリースに変化

ズボンのしわが伸びている

スニーカーの雰囲気は悪くない

ダンスはスムーズ(この踊りは誰が考えたんだろう)

といった感じで、個人で遊ぶには充分なレベルです。

他の画像で実験

次の画像を使ってウサギを立たせようとしましたが、煙が少し動くだけで、立ち上がることなく失敗しました。

人間をモデルにしているのなら、ウサギではだめなのかもしれません。(ウサギとして認識されていないのかも)

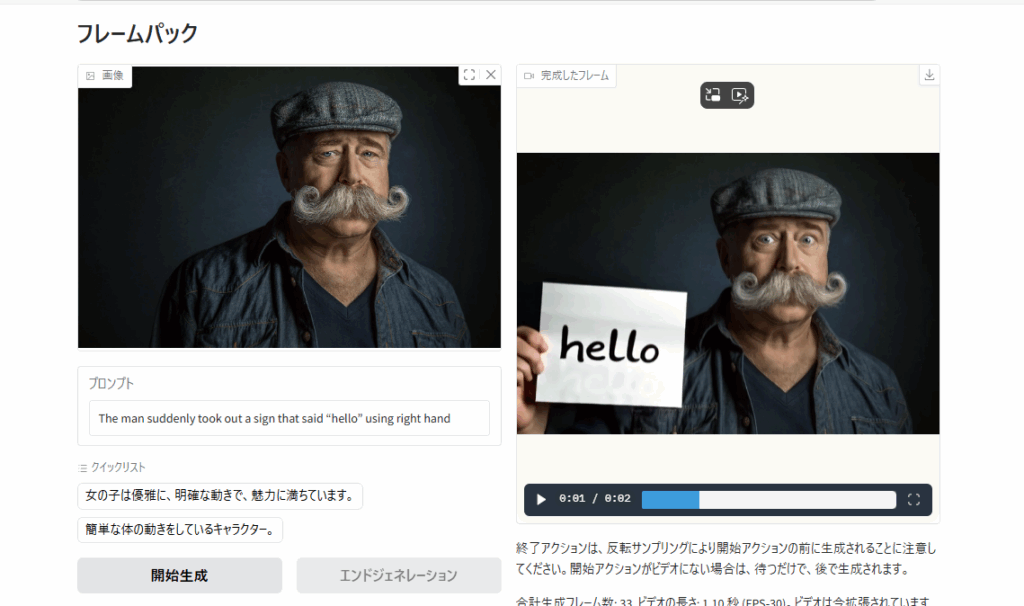

ヒゲのおじさんの画像を使ってみたところ、ちゃんと動作してくれました。

入力画像の右手が隠れているのに、出力動画に右手が表示されていることから、手を生成しているのがわかります。

2.5秒の動画を生成するのに、30分ちょっとかかりました。

袖口が少し不自然ですが、シード値を変えると、自然なものもありそうです。

生成した動画 2.5秒 mp4 1,049MB

ヒゲのおじさんが、いい表情になっています。good!

感想

手書きのイラストも動かせるのかと思い実験したのですが、私の画力がなさ過ぎてか、動画にしてもらうことはできませんでした。

英語でプロンプトを入力するのが一番大変ですが、AIを使えば日本語プロンプトも近いうちに可能になると思います。

ローカル環境で動くので、家族の写真を動画にしたり、踊っている友人をLINEで送っても楽しそうですね。