以前Dockerを使わない方法でWebUIを実装したのですが、最新のPythonにすると起動しないので、Dockerを使ってWebUIを実行するように変更しました。

10分もかからず構築できます。

準備

環境

Windows 11 Home

LLMサーバ Ollama version 0.5.4

GPU RTX4060 VRAM(8GB)

Dockerの準備

Dockerは、あらかじめ必要とされる環境を構築してあるVMのようなもの(コンテナ型仮想化技術を提供するプラットフォームと表現される)だと思っています。

DockerはホストOSのカーネルを使って、アプリケーションとその依存環境を「コンテナ」という単位で動作させます。

現在のプログラム開発では、さまざまな言語やフレームワークが複雑に組み合わされることが一般的ですので、開発や実行に必要な環境をあらかじめ構築したコンテナを作成し、Docker上でコンテナを共有することで、環境構築の手間を省き、開発効率を上げるのに使われています。

Dockerは、公式サイト(ウィンドウズ |Dockerのドキュメント)ここからダウンロードして、実行するだけでインストールできます。

本日のDocker最新バージョンは

docker 27.4.0

でした。

実行

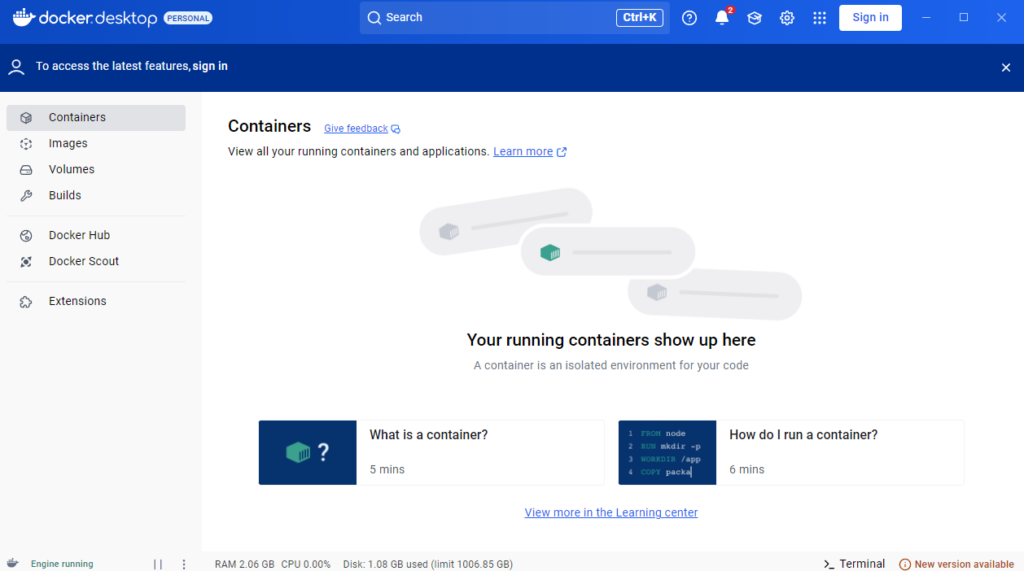

Dockerの実行

デスクトップのアイコンをダブルクリックしてDockerを起動します

アイコンをダブルクリックするだけです

職場で使っているアカウントでログインを求められますが、使っていないのでSKIP

簡単なログインアンケートに答えると起動します。

WebUIの実行

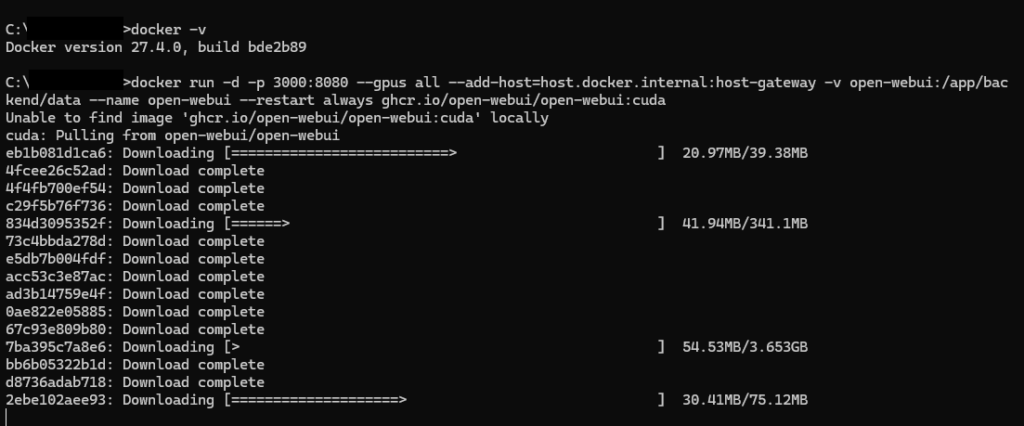

WebUIの公式サイト(🏡 ホーム |WebUIを開く)に起動方法が書かれているので、起動コマンドを入力します。

# CUDA を使わない方法で起動

c:\ > docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

# CUDA を使用する方法で起動

c:\ > docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda私はCUDAを使用する方を使いました。

コンテナのダウンロードは、5分くらいで完了しました。

すべてがcompleteになると準備完了です。

3000ポートが解放されていることがわかりますね。

Web-UIにアクセスする

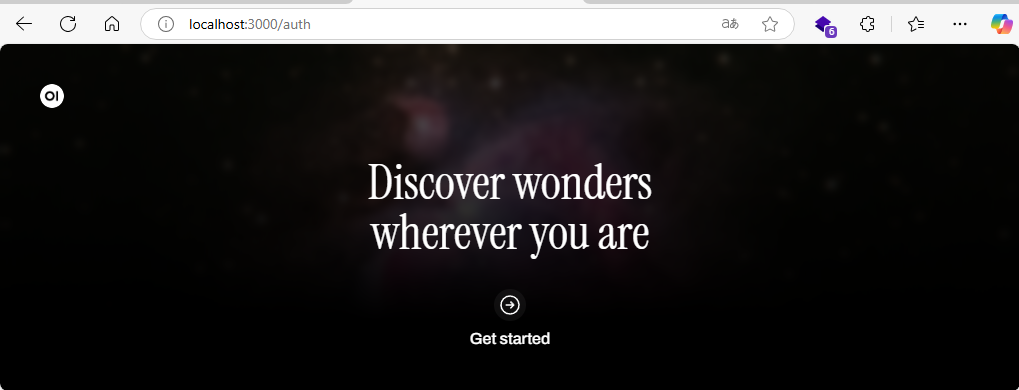

次のURL(http://localhost:3000)からWeb-UIにアクセスできます

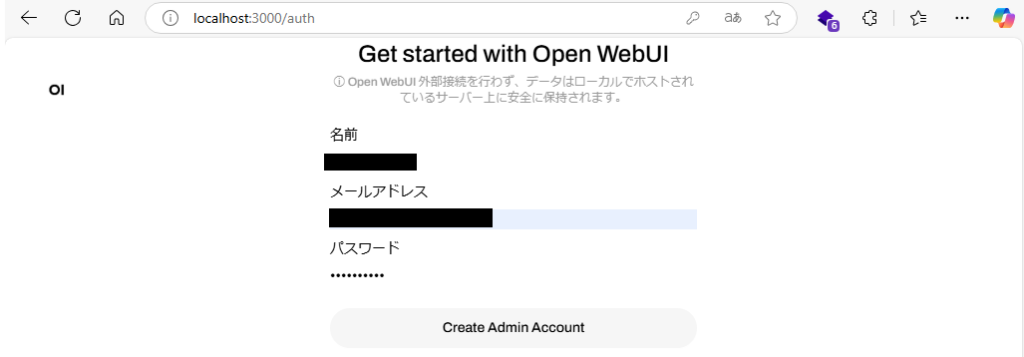

GetStandardを選択すると管理者の登録を行うことができます

データはローカルに保存されているのですが、管理者名とパスワードは使いまわさないことが重要です。

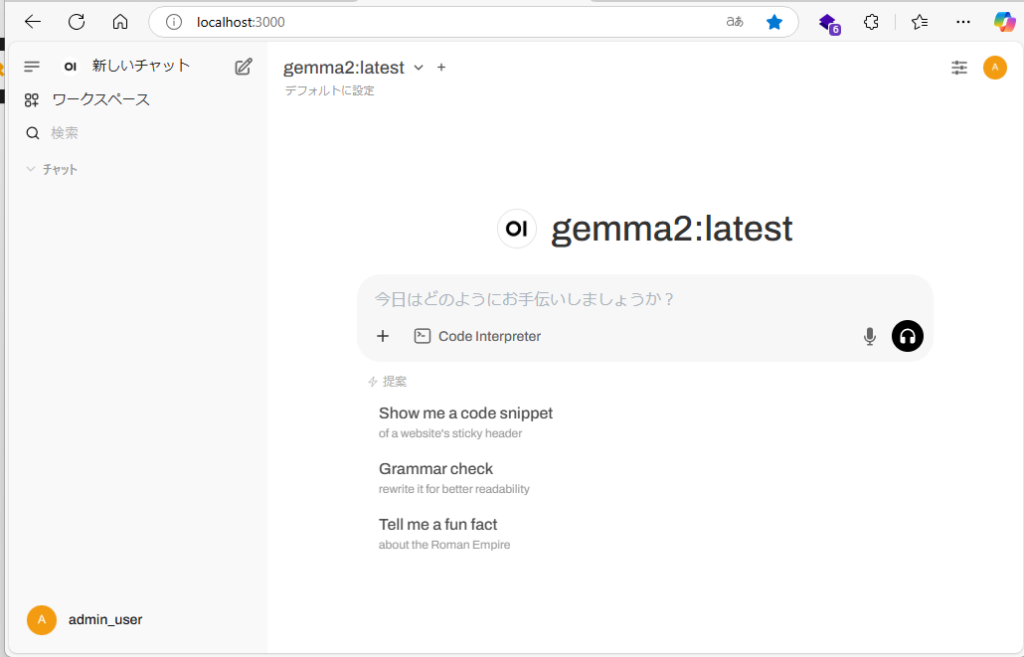

ローカル環境でWebUIが使えるようになります。

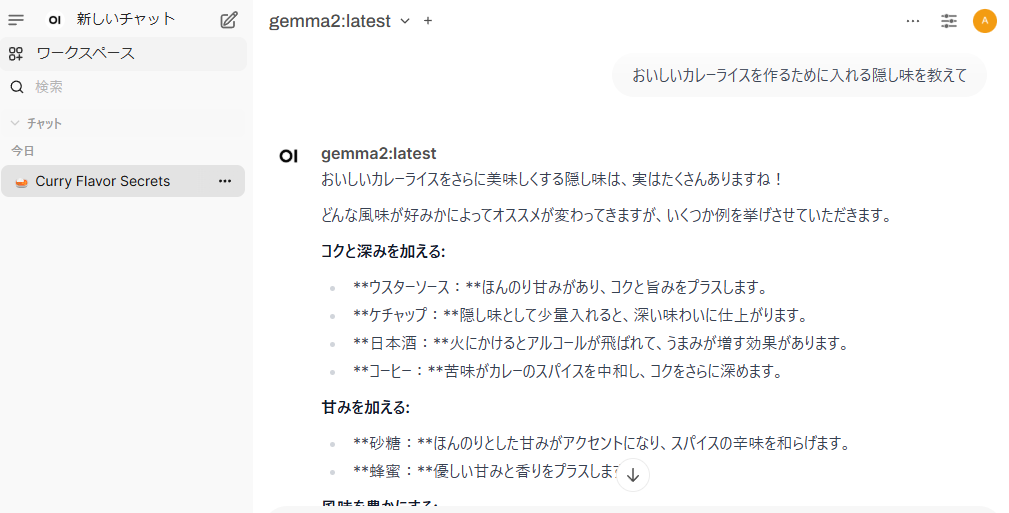

日本語で質問したところ、ちゃんと稼働していることがわかります。

最後に

Dockerのインストールは本当に簡単です。

本当に簡単に環境構築ができるのは素晴らしいと思います。

今後はこういうものが求められるのではないでしょうか。