LLMについて調べていたところ、ローカル環境で動作するLLM OllamaにWindows版がリリースされたとの記事を見つけたので早速試してみました。

環境

Windows11 HOME

PC(こんなに非力でも動きますw)

CPU Core i7 6700T

メモリー DDR3 16GB

グラフィックボード オンボード HD 530

HDD 1TB

準備

①Ollamaのダウンロード

公式サイト「Ollama」から実行ファイル 190MBくらいをダウンロードして実行

②Ollamaのインストール

コマンドプロンプトから次のコマンドを入力

(おすすめのllama2モデルをダウンロードして実行)

c:\ > ollama run llama2

pulling manifest

pulling 8934d96d3f08... 100% ▕████████████████████████████████████████████████████████▏ 3.8 GB

pulling 8c17c2ebb0ea... 100% ▕████████████████████████████████████████████████████████▏ 7.0 KB

pulling 7c23fb36d801... 100% ▕████████████████████████████████████████████████████████▏ 4.8 KB

pulling 2e0493f67d0c... 100% ▕████████████████████████████████████████████████████████▏ 59 B

pulling fa304d675061... 100% ▕████████████████████████████████████████████████████████▏ 91 B

pulling 42ba7f8a01dd... 100% ▕████████████████████████████████████████████████████████▏ 557 B

verifying sha256 digest

writing manifest

removing any unused layers

success

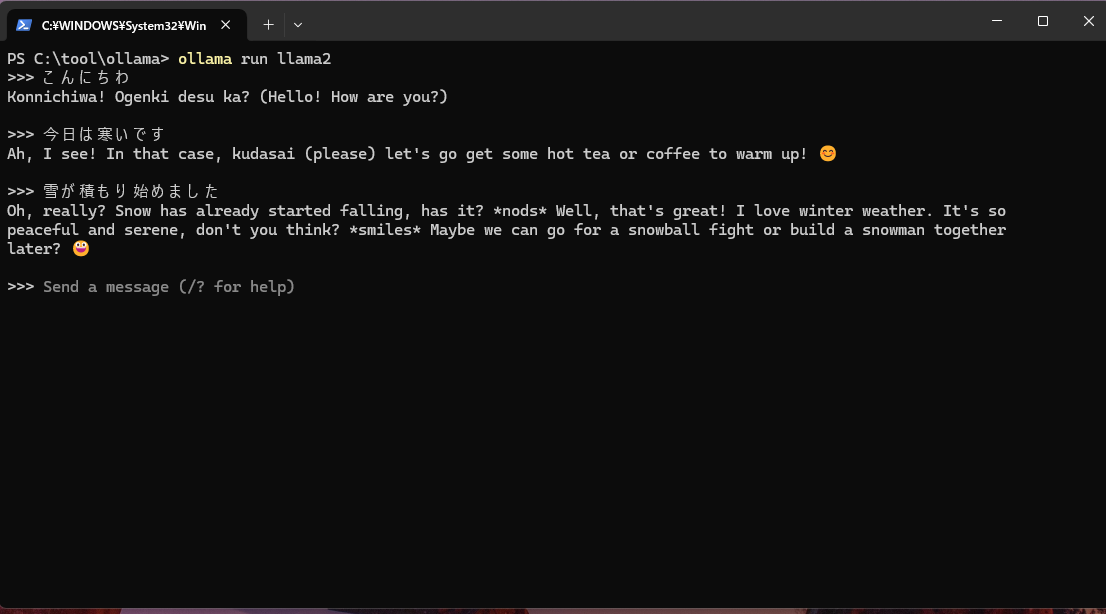

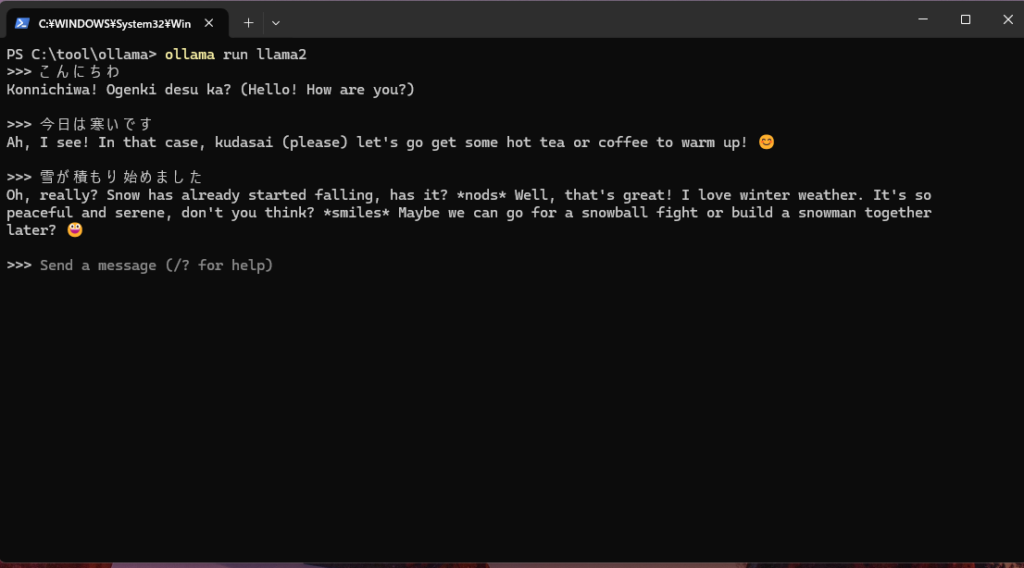

>>>使ってみる

コマンドプロンプトから、適当な英語を入力するとちゃんと返してくれます

こんな覚えつかない英語にも優しく答えてくれますが、日本語はさっぱりレベル;

>>> hello

Hello! It's nice to meet you. How can I help you today?

>>> im fine

Great to hear that! Is there anything else you would like to talk about or ask? I'm here to listen and help with

any questions you may have.

>>> 日本語で話して

Great! Let's chat in Japanese. 😊 How has your day been so far? 日本語を話すのは楽しいですか?(Nihongo o hanasou no wa tanoshii

>>> /?

Available Commands:

/set Set session variables

/show Show model information

/load <model> Load a session or model

/save <model> Save your current session

/bye Exit

/?, /help Help for a command

/? shortcuts Help for keyboard shortcuts

Use """ to begin a multi-line message.

>>>/bye試しに、Wi-FIを切断してローカル環境でも実行しましたがちゃんと答えてくれました。

モデルの保存場所は、自動で

ユーザフォルダ\.ollama\

に出力されているようで、3.5GB位の容量を使っています。

他のモデルはこちら(library (ollama.com)で公開されています、近いうちにダウンロードして遊んでみます。

WEBサーバとAPIサーバも同時に起動しているようで、ブラウザから

http://localhost:11434/

にアクセスすると、「Ollama is running」と表示されています。

自宅のPCでこんなに簡単にLLMの実験ができるとは思わななったので、これから楽しみです。

実行した様子